L’industrie technologique se prépare à une nouvelle vague d’appareils portables et Google a involontairement révélé quelques détails intéressants sur le logiciel qui accompagnera ses lunettes intelligentes tant attendues.

Cette découverte offre un regard fascinant sur la manière dont le géant de Mountain View imagine l’interaction entre les utilisateurs et la technologie portable dans les années à venir.

Une découverte fortuite révèle les plans de Google

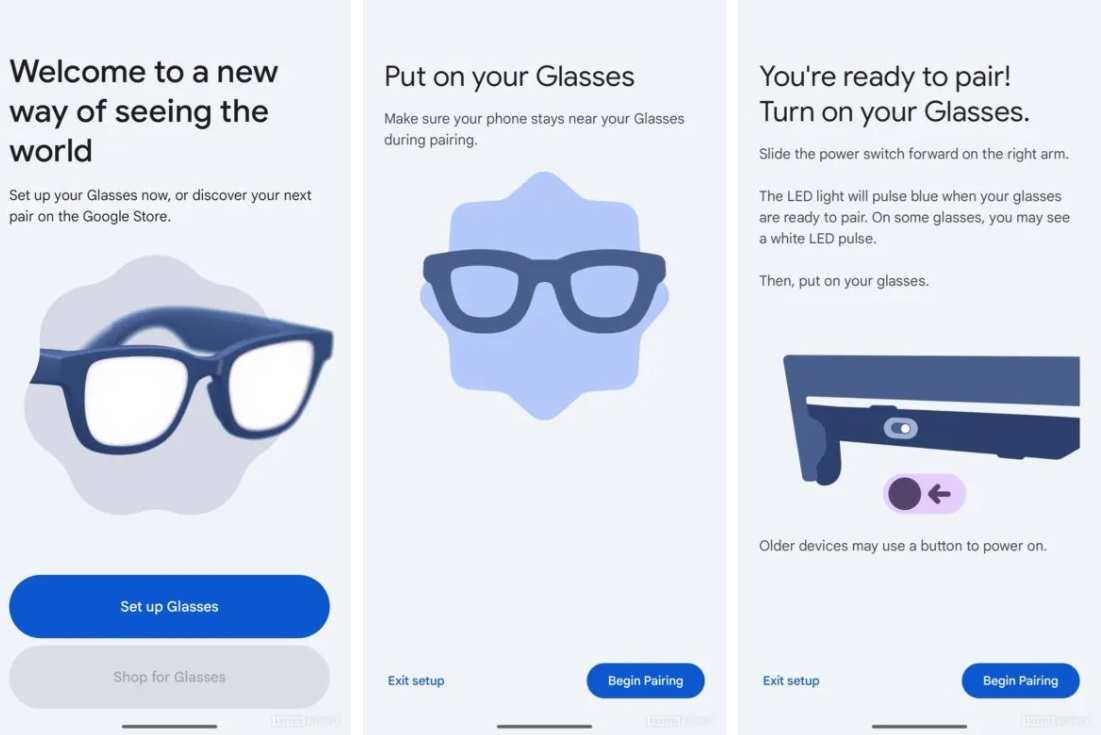

La révélation est arrivée presque par hasard sur le réseau de la communauté des développeurs Android. Un utilisateur de Reddit, en fouillant dans les détails de l’aperçu d’Android Studio avec les API définies sur la version Canary, a réussi à extraire l’application compagnon destinée aux lunettes intelligentes de Google.

Le logiciel, identifié par le nom du package com.google.android.glasses.companionest le pont entre les lunettes intelligentes et le smartphone de l’utilisateur, responsable de ce qui devrait être une expérience qui promet d’être fluide et intuitive.

Bien que l’application ne puisse pas être entièrement testée sans le matériel réel des lunettes, l’analyse du code et des chaînes de texte intégrées dans l’APK nous a permis de reconstituer une image précise des fonctionnalités que Google développe.

Certaines captures d’écran correspondent à ce que Google a déjà documenté dans son support officiel, tandis que d’autres semblent mises à jour, suggérant une évolution continue du projet.

Suivez Google Italia sur Telegram, recevez en premier les actualités et les offres

Comment fonctionnent les notifications intelligentes

L’une des fonctionnalités les plus intrigantes ressortant de l’analyse concerne la gestion intelligente des notifications. Google développe en effet un système sophistiqué qui utilise Gemini, son intelligence artificielle, pour détecter automatiquement quand l’utilisateur est engagé dans une conversation. À ces moments-là, les lunettes feront taire les notifications vocales, évitant ainsi les interruptions embarrassantes ou gênantes lors d’interactions sociales importantes.

Ce qui rend cette fonctionnalité particulièrement intéressante, c’est l’approche de Google en matière de confidentialité. D’après ce qui ressort du code, en fait, tout le processus de détection de conversation se déroulera directement sur les lunettes, sans que l’audio brut, les images ou les données conversationnelles ne soient partagées avec Google ou d’autres services. Un choix qui constitue un tournant intéressant et significatif, compte tenu des problèmes de confidentialité qui ont accompagné les précédentes tentatives de Google dans le domaine des lunettes intelligentes, comme les célèbres Google Glass.

Les utilisateurs auront également la possibilité de suspendre manuellement les notifications vocales, les options semblant inclure des intervalles par défaut d’une, deux, quatre ou huit heures.

Toutes les lunettes ne sont pas identiques

L’analyse du code révèle également que Google envisage une stratégie produit différenciée. Toutes les lunettes intelligentes n’auront pas accès aux mêmes fonctionnalités que Gemini, et le logiciel inclut déjà des messages qui informent les utilisateurs lorsque leur matériel n’est pas éligible à certaines fonctionnalités avancées.

La stratégie semble cohérente, d’un point de vue technique, avec le positionnement de Google : les fonctionnalités avancées d’IA nécessitent une puissance de calcul importante, et les limiter au matériel le plus performant garantit une expérience utilisateur optimale plutôt que compromise.

Il est vrai qu’un tel choix soulève également des questions sur la rapidité avec laquelle cette technologie deviendra obsolète et sur la manière dont Google gérera la mise à jour de son écosystème de wearables au fil du temps.

Bonne souplesse d’utilisation : du mode audio uniquement à l’affichage complet

L’une des révélations les plus intéressantes concerne le mode « audio uniquement » que Google met en place. Alors que la société a déjà annoncé son intention de lancer dans un premier temps des lunettes intelligentes sans écran, en se concentrant uniquement sur l’audio, le code suggère que les futurs modèles équipés d’un écran offriront également la possibilité d’éteindre l’écran et d’utiliser l’appareil en mode purement audio.

Le choix de conception répond en réalité à divers besoins pratiques. Tout d’abord, prolongez la durée de vie de la batterie lorsque vous n’avez pas besoin de sortie visuelle. Deuxièmement, réduisez les distractions dans les situations où l’utilisateur souhaite rester plus présent dans le monde physique. Troisièmement, proposez une option à ceux qui apprécient l’assistance vocale mais trouvent les écrans montés sur des lunettes trop invasifs ou distrayants.

La présence de commandes pour la luminosité de l’écran confirme que Google réfléchit à la manière dont ces appareils seront utilisés dans diverses conditions environnementales.

La caméra : des fonctionnalités avancées axées sur la confidentialité

La capacité d’enregistrement vidéo apparaît comme une autre fonctionnalité clé des lunettes intelligentes de Google. Le code fait référence à des résolutions vidéo jusqu’à 3K, bien que cette option soit qualifiée d’expérimentale, ce qui suggère qu’elle n’est peut-être pas disponible sur tous les modèles ou qu’elle est peut-être encore en cours d’optimisation. La présence d’une option 1080P plus standard indique que Google tente d’équilibrer la qualité de l’image et les performances de l’appareil.

Il convient particulièrement de noter le système de sécurité mis en place pour empêcher les enregistrements secrets. Le code suggère l’existence de mécanismes qui empêchent l’enregistrement vidéo lorsque la LED « enregistrement » est atténuée ou bloquée. Une fonctionnalité qui répond directement à l’une des critiques les plus virulentes adressées aux Google Glass originales, perçues comme des outils de surveillance invasifs. Au lieu de cela, Google semble déterminé à éviter de répéter les erreurs du passé en intégrant la transparence directement dans le matériel et les logiciels.