Dans un secteur où chaque génération de matériel semble durer moins qu’une mode technologique, Microsoft a encore franchi un pas. La société Redmond a présenté le nouvelle série de Machines virtuelles NDv6 GB300propulsé par un colosse d’ingénierie : un Cluster de production à l’échelle industrielle avec les systèmes NVIDIA GB300 NVL72conçu pour les charges de travail d’inférence d’IA les plus exigeantes.

Derrière cette annonce il y a bien plus que des spécifications techniques. Il y a une déclaration d’intention : Azure ne veut pas être simplement un cloud pour exécuter l’intelligence artificielle, mais l’infrastructure où se définit l’avenir de l’IA.

Un saut d’échelle qui redéfinit ce que signifie « cloud »

Le nouveau cluster NDv6 GB300 est, en pratique, un supercalculateur distribué capable de traiter des modèles qui nécessitaient auparavant des infrastructures distinctes ou dédiées. Avec plus de 4 600 GPU NVIDIA Blackwell Ultra connectés via le réseau NVIDIA Quantum-X800 InfiniBandle système amène le concept « hyperscale » sur un terrain qui, jusqu’à récemment, n’était occupé que par des laboratoires gouvernementaux ou des centres de recherche.

propre Nidhi Chappellvice-président d’AI Infrastructure chez Azure, l’a résumé avec une phrase calculée : « Il ne s’agit pas seulement de puissance brute ; il s’agit d’optimiser chaque couche du centre de données moderne pour l’IA. »

Cette phrase contient la clé de ce que Microsoft a réalisé: Repensez le matériel, la mémoire, la mise en réseau et le refroidissement comme un seul organisme.

À l’intérieur du moteur : 72 GPU par rack, refroidissement liquide et énorme mémoire

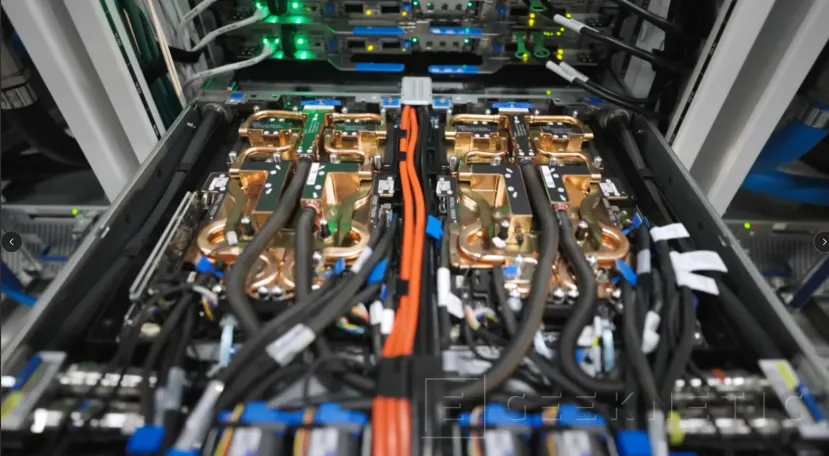

Le cœur de chaque machine virtuelle NDv6 GB300 est le système NVIDIA GB300 NVL72une unité à rack refroidie par liquide avec une densité effrayante. Chaque module intègre 72 GPU Blackwell Ultra et 36 processeurs Gracetous interconnectés via Commutateur NVLink de 5e génération.

Le résultat est un machine virtuelle avec 37 To de mémoire rapide et 1,44 exaflops de performances FP4 Tensor Coreun chiffre qui, il y a seulement trois ans, aurait semblé relever de la science-fiction. Cet espace mémoire unifié est ce qui vous permet de former et d’exécuter des modèles de raisonnement multimodal et d’intelligence artificielle (les mêmes que ceux sur lesquels travaille OpenAI, le principal partenaire d’Azure) sans latence ni fragmentation des données qui ralentissent le processus.

Blackwell Ultra, le joyau de NVIDIA pour 2025, n’est pas uniquement conçu pour la force brute. Son architecture intègre Formats de précision NVFP4qui réduisent la consommation et doublent les performances par rapport aux générations précédentes, en plus de Dynamo NVIDIAune technologie qui optimise l’inférence dynamique dans les modèles de raisonnement.

Dans les derniers benchmarks Inférence MLPerf v5.1cette combinaison a atteint des performances jusqu’à cinq fois supérieures à celles de l’architecture Hopper, établissant de nouveaux records dans des modèles tels que DeepSeek-R1 (671 B de paramètres) ou Llama 3.1 405B.

Un réseau à la hauteur : NVLink et Quantum-X800

Toute cette puissance serait inutile sans un réseau capable de déplacer les données à la même vitesse. Microsoft et NVIDIA ont conçu un architecture d’interconnexion à deux niveaux: vertical, à l’intérieur de chaque rack, et horizontal, entre racks.

à l’intérieurle système NVLink Switch offre 130 To/s de bande passante directe entre les 72 GPU d’un rack, agissant comme un accélérateur unique avec mémoire partagée. À l’étrangerle réseau Quantum-X800 InfiniBand connecte plus de 4 600 puces avec 800 Go/s par GPU, pris en charge par les commutateurs Quantum-X800 et les cartes ConnectX-8 SuperNIC.

Cette combinaison permet un modèle d’IA de milliards de paramètres Travaillez comme si vous vous entraîniez sur une seule machine gigantesque. De plus, le réseau utilise la télémétrie active et le contrôle adaptatif de la congestion, ainsi que le protocole SHARP v4 de NVIDIA, qui réduit les opérations et regroupe les données directement dans le matériel, multipliant ainsi l’efficacité de la formation et de l’inférence.

Une collaboration de plusieurs années entre géants

L’annonce d’Azure n’est pas sortie de nulle part. Microsoft et NVIDIA travaillent en tandem depuis plusieurs années pour construire l’infrastructure qui prend en charge les avancées d’OpenAI et d’autres entreprises formant des modèles de nouvelle génération.

Ce cluster NDv6 GB300 est le résultat de cette collaborationmais aussi un investissement stratégique pour le pays : il renforce la position des États-Unis comme épicentre du développement de l’IA avancée et réduit la dépendance vis-à-vis des infrastructures étrangères.

Selon des sources proches du projet, la construction de ce système a nécessité de revoir chaque couche du data center Azure, depuis la conception du refroidissement liquide et de la distribution électrique, jusqu’à une nouvelle pile logicielle d’orchestration et de stockage adaptée à l’échelle des modèles actuels.

Et ensuite : le cloud comme supercalculateur mondial

L’objectif de Microsoft n’est pas seulement de proposer un nouveau type de machine virtuelle, mais de faire d’Azure un réseau de supercalculateurs modulaires capables de croître sans limites. Le NDv6 GB300 est le premier bloc visible de ce plan.

Alors que la société étend sa flotte à des centaines de milliers de GPU Blackwell Ultra, l’impact sera double– offrira à des clients comme OpenAI une plateforme aux performances sans précédent tout en démocratisant l’accès aux ressources informatiques extrêmes pour les startups, les universités et les développeurs.

Avec cette version, Microsoft ne construit pas seulement l’infrastructure qui alimentera la prochaine vague de modèles d’IA. Elle dessine le squelette de l’avenir numérique : un cloud qui n’est plus un service distant, mais un supercalculateur mondial partagé.