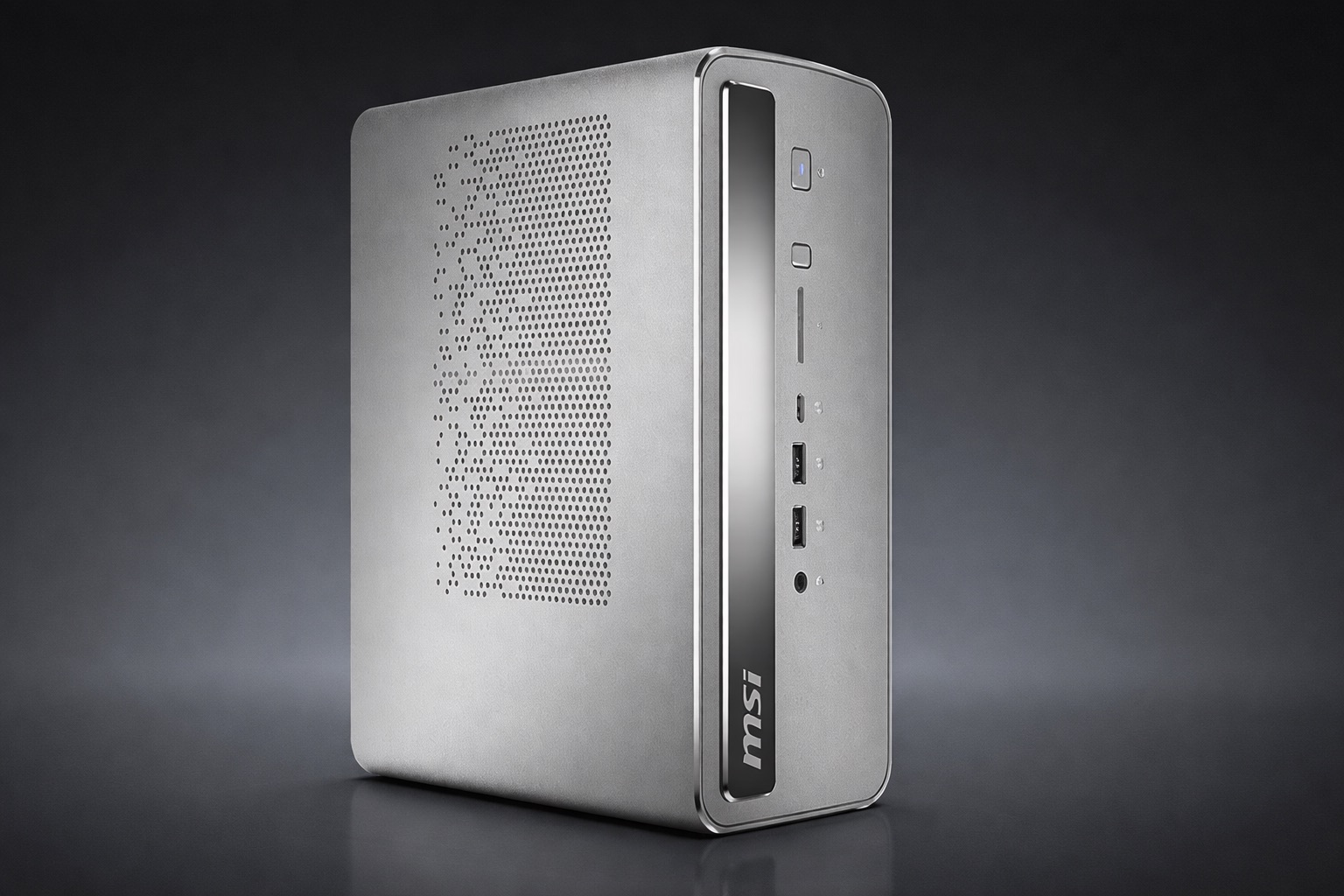

L’année dernière, l’IA est devenue quotidienne : résumé de réunion, recherche de documents et assistants pour la planification ou la rédaction. Le problème est que l’expérience dépend souvent du cloud. Lorsque tout passe par des serveurs externes, trois freins évidents apparaissent : latence, coûts récurrents et inconvénients liés au téléchargement d’informations sensibles. C’est pourquoi il MSI AI Edge Présenté au CES 2026, il attire l’attention : un ordinateur de bureau compact de 4 litres conçu pour exécuter l’inférence IA sur l’ordinateur lui-même.

MSI l’encadre dans le concept Edge AI et il s’appuie sur une combinaison qui, sur le papier, s’attaque au grand goulot d’étranglement de l’IA sur PC : la mémoire disponible pour la partie graphique. Au lieu de s’appuyer sur une carte dédiée avec une VRAM limitée, l’AI Edge s’articule autour Plateforme Strix Halo d’AMD et son approche de mémoire unifiée.

Un petit châssis qui se concentre sur la stabilité, pas sur les sommets

L’AI Edge se veut vraiment compact. MSI le décrit comme un système de 4 litres avec une alimentation intégrée, évitant le bloc externe typique. Pourtant, ce qui compte, c’est une performance durable. L’inférence de l’IA peut être un fardeau continu, et dans un petit châssis, la température décide de ses performances réelles.

Pour maintenir la stabilité, MSI mentionne son Solution thermique Glacier Armoravec une dissipation renforcée dans les composants clés. L’idée est que l’équipement n’a pas besoin de couper les fréquences dès qu’il accumule de la chaleur, ce qui est bien plus visible qu’une petite différence de spécifications lorsqu’on travaille depuis un certain temps.

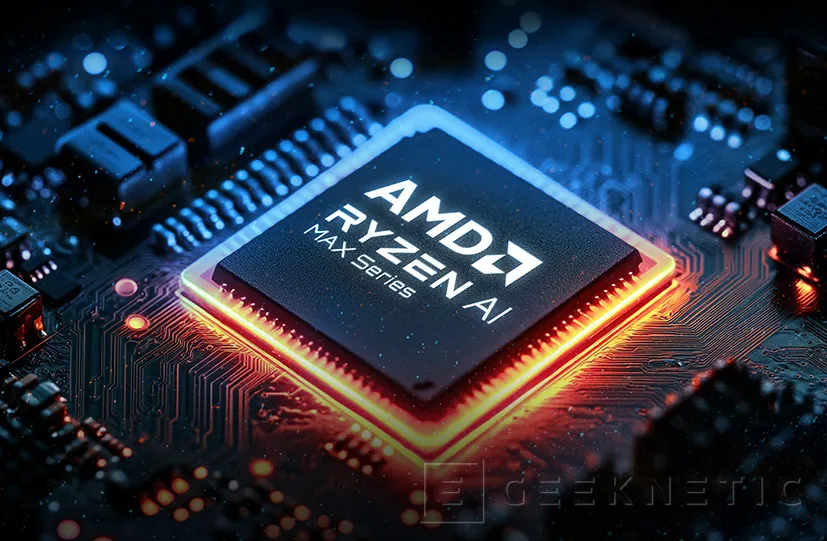

Ryzen AI Max+ 395 : Total TOPS et un NPU XDNA 2 avec du vrai poids

Le cœur de l’équipe est AMD Ryzen AI Max+ 395au sein de la famille Ryzen AI Max+ 300. MSI estime la performance totale de l’IA à jusqu’à 126 HAUTSajoutant CPU, GPU intégré et NPU. Dans cet ensemble, le XDNA 2 NPU fournit jusqu’à 50 TOPS théoriques.

Cette répartition est importante car elle permet de choisir où chaque partie du travail est exécutée. Il existe des tâches qui s’intègrent bien dans un NPU pour plus d’efficacité, d’autres qui utilisent le GPU pour l’alimentation et d’autres qui sont mieux résolues sur le CPU. La promesse ici n’est pas seulement de la puissance brute, mais une plate-forme unifiée où vous pouvez répartir les charges sans toujours dépendre d’une carte graphique dédiée.

Mémoire unifiée : jusqu’à 128 Go et 96 Go attribuables au GPU

La caractéristique déterminante de l’AI Edge est la mémoire. MSI indique que le système peut intégrer jusqu’à 128 Go de mémoire LPDDR5X 8000 intégréesous un schéma de mémoire unifié. Et ajoutez une information clé : Jusqu’à 96 Go peuvent être alloués dynamiquement au GPU intégré, basé sur RDNA 3.5 avec 40 unités de calcul.

Cela nous amène directement au problème le plus courant lors de l’exécution de grands modèles sur un PC conventionnel : la VRAM. Vous pouvez avoir beaucoup de RAM, mais si votre GPU reste à 8 ou 12 Go de VRAM, le modèle se heurte à un mur et doit réduire la taille ou assumer des performances irrégulières. Avec des dizaines de gigaoctets attribuables, la marge change d’échelle et la machine devient plus flexible pour l’inférence locale.

MSI affirme que l’appareil peut déplacez des modèles de langage comprenant jusqu’à 120 milliards de paramètres et obtenez une sortie de 15 jetons par seconde. Ce sont des chiffres de référence, mais ils aident à comprendre l’objectif : qu’il ne s’agit pas d’une démonstration ponctuelle, mais plutôt d’un outil capable de gérer de grands modèles à une cadence utilisable.

Windows ou Linux et flux avec RAG pour travailler avec vos données

Autre détail pratique, l’AI Edge est conçu pour pouvoir travailler avec Windows ou Linux. Dans une équipe de pointe orientée vers l’IA, cette dualité convient : Linux reste l’habitat naturel de nombreuses piles d’IA, tandis que Windows est la clé de la productivité et des logiciels professionnels.

MSI parle également d’un application locale axée sur la productivité et mentionne l’intégration de RAG (Récupération de génération augmentée): combinez un modèle avec une couche de recherche au-dessus de vos propres documents pour répondre avec un contexte réel. Au lieu de demander au modèle d’improviser, le système consulte les fichiers locaux et construit des réponses avec ces informations.

MSI essaie de garantir que l’AI Edge ne soit pas catalogué comme un ordinateur uniquement IA. C’est pourquoi il mentionne qu’il peut offrir une expérience de jeu comparable à une GeForce RTX 4060. Ce n’est pas une équivalence exacte des tests, mais c’est un message sur la puissance du Strix Halo iGPU et son intention de servir de bureau général.

Le message sous-jacent est clair : une partie de l’IA revient dans l’appareil. Cela réduit la latence, évite de dépendre des services et renforce le contrôle sur les données sensibles. Sans connaître le prix et la disponibilité, MSI a déjà défini une recette : 4 litres, plateforme AMD puissante, mémoire unifiée très généreuse et focus sur l’inférence locale, avec de la place pour des usages généraux.